A modern vállalatok naponta hatalmas mennyiségű adatot generálnak és tárolnak, ami egyre nagyobb kihívást jelent az IT infrastruktúra számára. A redundáns adatok kezelése nemcsak költséges, hanem jelentősen befolyásolja a rendszer teljesítményét és a biztonsági mentések hatékonyságát is.

Az adatdeduplikáció egy olyan technológia, amely azonosítja és eltávolítja a duplikált adatblokkokat a tárolórendszerből. Ez a folyamat különböző szinteken történhet meg – fájl-, blokk- vagy byte-szinten -, és számos megközelítést alkalmazhat. A technológia célja, hogy maximalizálja a tárolókapacitás kihasználását és csökkentse a tárolási költségeket.

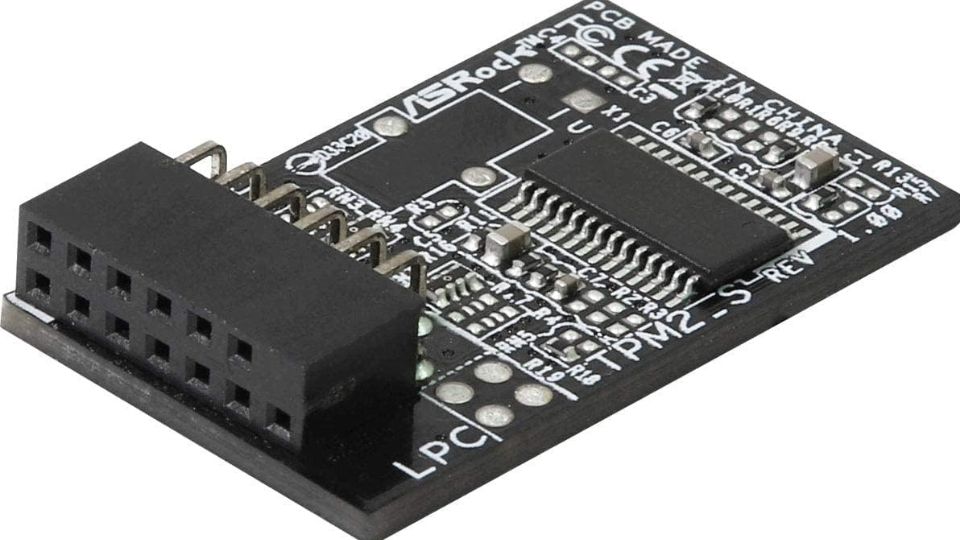

Ez az útmutató részletesen bemutatja a deduplikációs hardverek világát, működési elveiket, típusaikat és gyakorlati alkalmazásukat. Megismerheted a különböző technológiák előnyeit és hátrányait, valamint azt, hogyan választhatod ki a legmegfelelőbb megoldást a vállalati igényekhez.

A deduplikációs technológia alapjai

A deduplikáció lényege az azonos adatblokkok felismerése és egyetlen példányban történő tárolása. Ez a folyamat hash algoritmusok segítségével történik, amelyek egyedi ujjlenyomatot készítenek minden adatblokkról. Amikor egy új adatblokk érkezik, a rendszer összehasonlítja annak hash értékét a már tárolt blokkok ujjlenyomataival.

A technológia működése során a rendszer egy metaadat-táblázatot vezet, amely tartalmazza az összes tárolt blokk hash értékét és fizikai helyét. Ha egy új adatblokk hash értéke megegyezik egy már tárolt blokk értékével, akkor a rendszer csak egy referenciát hoz létre az eredeti blokkra, és nem tárolja újra az adatot.

Inline és post-process deduplikáció

Inline deduplikáció esetén az adatok deduplikálása már az írási folyamat során megtörténik. Ez azonnali tárolóhely-megtakarítást eredményez, azonban nagyobb számítási teljesítményt igényel, ami hatással lehet az írási sebességre.

Post-process deduplikáció során az adatok először a hagyományos módon kerülnek tárolásra, majd később, általában kevésbé forgalmas időszakokban történik meg a deduplikálás. Ez kisebb hatással van a rendszer teljesítményére, de késlelteti a tárolóhely-megtakarítás realizálását.

A két megközelítés között való választás függ a vállalat prioritásaitól: az azonnali tárolóhely-megtakarítás vagy a stabil teljesítmény fontosabb-e.

Deduplikációs hardverek típusai

Céleszköz-alapú deduplikációs rendszerek

A céleszköz-alapú megoldások speciálisan deduplikációra optimalizált hardvereszközök. Ezek általában biztonsági mentési környezetekben találhatók meg, ahol a deduplikációs arány különösen magas lehet.

Ezek a rendszerek integrált szoftver- és hardvermegoldást kínálnak. A beépített deduplikációs algoritmusok és a speciális tárolóarchitektúra együttesen biztosítják a magas teljesítményt és hatékonyságot.

A céleszköz-alapú megoldások előnye, hogy a gyártó optimalizálta a hardvert és szoftvert egymáshoz. Ez általában jobb teljesítményt és megbízhatóságot eredményez, mint a különálló komponensek összeillesztése.

Szoftveralapú deduplikáció speciális hardveren

Bizonyos esetekben a szoftveralapú deduplikációs megoldások speciális hardveren futnak. Ez lehet nagy teljesítményű szerver megfelelő processzorral, memóriával és tárolókapacitással.

Az ilyen megoldások rugalmasabbak, mivel a szoftver frissíthető és testreszabható. A hardver kiválasztása során figyelembe kell venni a deduplikációs algoritmus számítási igényeit és a várható adatátviteli sebességet.

A deduplikáció során a hash számítások és az összehasonlítások jelentős processzorteljesítményt igényelnek. Ezért fontos a megfelelő CPU kiválasztása, lehetőleg több maggal és nagy cache memóriával.

Teljesítményoptimalizálás és skálázhatóság

Memóriahasználat optimalizálása

A deduplikációs rendszerek teljesítménye nagyban függ a rendelkezésre álló memória mennyiségétől. A hash táblázatok memóriában való tárolása jelentősen felgyorsítja a deduplikációs folyamatot.

A working set koncepció alapján a leggyakrabban használt hash értékeket érdemes memóriában tartani. Ez csökkenti a lemezre való hozzáférések számát és javítja a rendszer válaszidejét.

Nagyobb adatmennyiségek esetén hierarchikus tárolási stratégia alkalmazható. A gyakran használt metaadatok gyors SSD-ken, míg a ritkábban használt információk hagyományos merevlemezeken tárolhatók.

Párhuzamos feldolgozás

A modern deduplikációs hardverek többszálú feldolgozást támogatnak. Ez lehetővé teszi több adatstream egyidejű deduplikálását, ami jelentősen növeli az átbocsátóképességet.

A párhuzamosítás során figyelembe kell venni a hash táblázatok konzisztenciáját. Megfelelő szinkronizációs mechanizmusokra van szükség annak érdekében, hogy elkerüljük az adatsérülést.

Load balancing technikák alkalmazásával biztosítható, hogy a rendszer erőforrásai optimálisan legyenek kihasználva. Ez különösen fontos nagy terhelés esetén.

Biztonsági szempontok és adatvédelem

Hash ütközések kezelése

Bár a kriptográfiai hash függvények ütközése rendkívül ritka, a deduplikációs rendszereknek fel kell készülniük erre az eshetőségre. Hash ütközés esetén két különböző adatblokk ugyanazt a hash értéket kapná.

A megbízható deduplikációs rendszerek többlépcsős ellenőrzést alkalmaznak. Ha a hash értékek megegyeznek, byte-szintű összehasonlítás történik annak megerősítésére, hogy valóban azonos adatokról van-e szó.

Bizonyos implementációk több hash algoritmust használnak egyidejűleg. Ez tovább csökkenti az ütközés valószínűségét, azonban növeli a számítási komplexitást.

Adatintegritás biztosítása

A deduplikáció során kritikus fontosságú az adatintegritás megőrzése. Ha egy deduplikált blokk megsérül, az hatással lehet minden olyan fájlra, amely hivatkozik rá.

Checksumok és hibajavító kódok alkalmazásával biztosítható az adatok integritása. Ezek lehetővé teszik a sérült blokkok felismerését és bizonyos esetekben helyreállítását is.

Redundáns tárolás alkalmazható a kritikus metaadatok számára. A hash táblázatok és referenciák több példányban való tárolása növeli a rendszer megbízhatóságát.

"A deduplikáció nemcsak tárolóhelyet spórol, hanem alapvetően megváltoztatja az adatkezelési stratégiákat és új biztonsági megfontolásokat vet fel."

Hálózati deduplikáció és WAN optimalizálás

Forrás-oldali deduplikáció

A forrás-oldali deduplikáció során a deduplikálás már az adatok küldése előtt megtörténik. Ez jelentősen csökkenti a hálózati forgalmat, különösen biztonsági mentések esetén.

Az ügyfél-oldali ügynök szoftver azonosítja a már korábban továbbított adatblokkokat. Csak az új vagy módosított blokkok kerülnek átvitelre a hálózaton keresztül.

Ez a megközelítés különösen hatékony olyan környezetekben, ahol korlátozott sávszélesség áll rendelkezésre. A hálózati forgalom csökkenése gyorsabb biztonsági mentéseket és helyreállításokat tesz lehetővé.

Cél-oldali deduplikáció

Cél-oldali deduplikáció esetén az adatok a teljes mennyiségben kerülnek átvitelre, és a deduplikálás a célhelyen történik meg. Ez nagyobb hálózati forgalmat jelent, azonban egyszerűbb implementációt tesz lehetővé.

A megközelítés előnye, hogy nem igényel speciális ügyfél-oldali szoftvert. A meglévő biztonsági mentési folyamatok módosítás nélkül használhatók.

Hibrid megoldások is léteznek, amelyek kombinálják a két megközelítést. Az intelligens algoritmusok döntik el, hogy mikor érdemes forrás-oldali, és mikor cél-oldali deduplikálást alkalmazni.

Teljesítménymérés és monitorozás

| Metrika | Leírás | Optimális érték |

|---|---|---|

| Deduplikációs arány | Tárolóhely-megtakarítás százaléka | 70-90% |

| Throughput | Feldolgozott adatmennyiség időegység alatt | Alkalmazásfüggő |

| Latencia | Válaszidő deduplikálási műveletekre | < 10ms |

| CPU használat | Processzor kihasználtság | < 80% |

| Memória használat | RAM kihasználtság | < 85% |

Kulcsfontosságú teljesítménymutatók

A deduplikációs rendszerek teljesítményének értékelése során több metrikát kell figyelembe venni. A deduplikációs arány mutatja meg, hogy mekkora tárolóhely-megtakarítás érhető el.

A throughput jelzi, hogy mennyi adat dolgozható fel időegységenként. Ez különösen fontos biztonsági mentési ablakokban, ahol korlátozott idő áll rendelkezésre.

A latencia mérése segít megérteni, hogy a deduplikáció mennyire befolyásolja a felhasználói élményt. Túl magas latencia esetén az alkalmazások teljesítménye romlhat.

Kapacitástervezés

A deduplikációs rendszerek kapacitástervezése összetett feladat. Figyelembe kell venni a várható adatnövekedést, a deduplikációs arányt és a teljesítménykövetelményeket.

Történeti adatok elemzése segíthet a jövőbeli igények előrejelzésében. Az adattípusok és -források változása jelentősen befolyásolhatja a deduplikációs hatékonyságot.

Skálázhatósági tesztek elvégzése javasolt a termelésbe állítás előtt. Ez segít azonosítani a potenciális szűk keresztmetszeteket és optimalizálási lehetőségeket.

Integrációs kihívások és megoldások

Meglévő infrastruktúrával való integráció

A deduplikációs megoldások bevezetése során gyakran kihívást jelent a meglévő infrastruktúrával való integráció. A hagyományos biztonsági mentési folyamatok módosítására lehet szükség.

API-k és protokollok kompatibilitása kritikus fontosságú. A deduplikációs rendszernek támogatnia kell a szervezetben használt biztonsági mentési szoftvereket és protokollokat.

Fokozatos migráció alkalmazása csökkentheti a kockázatokat. Pilot projektek segítségével tesztelhető a megoldás hatékonysága és kompatibilitása kisebb környezetekben.

Alkalmazás-specifikus optimalizálások

Különböző alkalmazástípusok eltérő deduplikációs karakterisztikákkal rendelkeznek. Az adatbázisok, e-mail rendszerek és fájlszerverek más-más megközelítést igényelnek.

Strukturált adatok esetén a deduplikáció hatékonysága gyakran alacsonyabb, mivel az adatok természetüknél fogva egyediek. Speciális algoritmusok fejlesztése szükséges lehet.

A virtualizált környezetek különleges lehetőségeket kínálnak a deduplikációra. A virtuális gépek lemezképei gyakran tartalmaznak azonos adatblokkokat.

"A sikeres deduplikációs implementáció kulcsa a megfelelő technológia kiválasztása és az alkalmazás-specifikus optimalizálások alkalmazása."

Költség-haszon elemzés

Beruházási költségek

A deduplikációs hardverek beszerzési költsége jelentős lehet, különösen nagy teljesítményű megoldások esetén. Figyelembe kell venni a hardver, szoftver és implementációs költségeket is.

TCO (Total Cost of Ownership) számítás során az üzemeltetési költségeket is be kell kalkulálni. Ez magában foglalja az energiafogyasztást, karbantartást és támogatást.

A licencelési modellek változatosak lehetnek. Egyes megoldások kapacitás alapján, mások pedig feldolgozott adatmennyiség alapján számlázzák a díjakat.

Megtérülési számítások

A deduplikáció ROI (Return on Investment) számításánál több tényezőt kell figyelembe venni. A tárolóhely-megtakarítás mellett a hálózati forgalom csökkenése és a biztonsági mentési idők rövidülése is értéket teremt.

Operációs költségmegtakarítások jelentősek lehetnek. Kevesebb tárolóeszköz karbantartása, alacsonyabb energiafogyasztás és csökkent adminisztrációs teher mind hozzájárulnak a megtérüléshez.

A kockázatcsökkentés értékének számszerűsítése nehéz, de fontos elem. A gyorsabb helyreállítási idők és a megbízhatóbb biztonsági mentések csökkentik az üzletmenet-folytonossági kockázatokat.

| Költségtényező | Hagyományos tárolás | Deduplikációs megoldás |

|---|---|---|

| Tárolókapacitás | 100% | 20-40% |

| Energiafogyasztás | 100% | 30-50% |

| Adminisztrációs idő | 100% | 60-80% |

| Biztonsági mentési ablak | 100% | 40-70% |

| Hálózati sávszélesség | 100% | 10-30% |

Jövőbeli trendek és fejlesztések

Mesterséges intelligencia alkalmazása

Az AI és gépi tanulás technológiák egyre nagyobb szerepet játszanak a deduplikációban. Intelligens algoritmusok képesek előre jelezni a deduplikációs mintákat és optimalizálni a folyamatokat.

Prediktív deduplikáció során a rendszer megtanulja az adatminták változásait és előre pozicionálja a gyakran használt hash értékeket a memóriában.

A gépi tanulás segíthet a hamis pozitívok csökkentésében és a hash ütközések jobb kezelésében. Adaptive algoritmusok dinamikusan állíthatják be a deduplikációs paramétereket.

Cloud-native megoldások

A felhő-alapú deduplikációs szolgáltatások növekvő népszerűségnek örvendenek. Ezek skálázható, költséghatékony alternatívát kínálnak a hagyományos hardver-alapú megoldásokkal szemben.

Hibrid felhő architektúrák lehetővé teszik a helyszíni és felhő-alapú deduplikáció kombinálását. A kritikus adatok helyben maradhatnak, míg az archív adatok a felhőbe kerülhetnek.

A serverless computing modellek új lehetőségeket nyitnak a deduplikáció számára. Az igény szerinti skálázás és a használat-alapú díjszabás vonzó lehet kisebb szervezetek számára.

"A deduplikációs technológiák jövője a mesterséges intelligencia és a felhő-alapú szolgáltatások integrációjában rejlik."

Implementációs útmutató

Előkészületi fázis

A deduplikációs projekt sikeres megvalósításához alapos előkészítés szükséges. Adatfelmérés elvégzése segít megérteni a meglévő adatstruktúrákat és deduplikációs potenciált.

A jelenlegi tárolási költségek és teljesítménymutatók dokumentálása baseline-t teremt a későbbi összehasonlításokhoz. Ez magában foglalja a tárolókapacitás használatot, biztonsági mentési időket és hálózati forgalmat.

Stakeholder bevonása kritikus fontosságú. Az IT csapat mellett az üzleti felhasználókat is be kell vonni a tervezési folyamatba, hogy megértsék az elvárásokat és korlátokat.

Pilot projekt végrehajtása

Kisebb környezetben végzett pilot teszt lehetővé teszi a technológia értékelését alacsony kockázat mellett. Válassz egy reprezentatív, de nem kritikus adathalmazt a teszteléshez.

A pilot során mérni kell a deduplikációs arányt, teljesítményt és felhasználói elégedettséget. Dokumentáld az esetleges problémákat és azok megoldásait.

Lessons learned összegyűjtése és elemzése segít a teljes körű implementáció finomhangolásában. A pilot tapasztalatai alapján módosítható a terv és az elvárások.

Éles környezetbe való átállás

A termelési környezetbe való átállás során fokozatos megközelítés javasolt. Kezd a kevésbé kritikus rendszerekkel és fokozatosan bővítsd a deduplikáció hatókörét.

Monitoring és alerting beállítása elengedhetetlen. A rendszer teljesítményének folyamatos figyelése segít az esetleges problémák korai felismerésében.

Biztonsági mentési és helyreállítási tervek kidolgozása szükséges a deduplikált adatok számára. Teszteld ezeket a folyamatokat rendszeresen.

"A sikeres implementáció kulcsa a fokozatos megközelítés és a folyamatos monitoring alkalmazása."

Hibakeresés és karbantartás

Gyakori problémák azonosítása

A deduplikációs rendszerekben fellépő problémák gyakran a teljesítmény romlásában vagy a deduplikációs arány csökkenésében nyilvánulnak meg. Hash táblázat fragmentáció okozhat lassulást.

Memóriahiány esetén a rendszer kénytelen lemezre írni a hash táblázatokat, ami jelentősen rontja a teljesítményt. Monitoring eszközökkel folyamatosan figyelni kell a memóriahasználatot.

Metaadat korrupció súlyos problémákat okozhat. Rendszeres konzisztencia ellenőrzések futtatása segít az ilyen problémák korai felismerésében.

Proaktív karbantartás

Rendszeres karbantartási feladatok elvégzése megelőzheti a komolyabb problémákat. Defragmentálás és optimalizálás javíthatja a rendszer teljesítményét.

A hash táblázatok időszakos újraépítése eltávolíthatja az elavult bejegyzéseket és javíthatja a keresési teljesítményt. Ezt általában kevésbé forgalmas időszakokban érdemes elvégezni.

Capacity planning folyamatos feladat. Az adatnövekedés és a deduplikációs arány változásainak figyelembe vétele szükséges a jövőbeli kapacitásigények előrejelzéséhez.

Teljesítményhangolás

A deduplikációs rendszerek teljesítménye számos paraméter finomhangolásával javítható. Chunk méret optimalizálása befolyásolja a deduplikációs arányt és a teljesítményt.

Kisebb chunk méret általában jobb deduplikációs arányt eredményez, azonban növeli a metaadat mennyiségét és a számítási komplexitást. A megfelelő egyensúly megtalálása kritikus.

Cache algoritmusok optimalizálása javíthatja a hash táblázatok elérési idejét. LRU (Least Recently Used) vagy adaptív cache stratégiák alkalmazása javasolt.

"A proaktív karbantartás és folyamatos optimalizálás elengedhetetlen a deduplikációs rendszerek hosszú távú hatékony működéséhez."

Megfelelőségi és auditálási szempontok

Adatmegőrzési szabályok

A deduplikációs környezetekben különös figyelmet kell fordítani az adatmegőrzési szabályoknak való megfelelésre. GDPR és egyéb adatvédelmi előírások speciális kihívásokat jelenthetnek.

Amikor egy deduplikált blokk törlésre kerül, biztosítani kell, hogy minden rá hivatkozó fájl megfelelően kezelve legyen. Ez összetett referencia-követési mechanizmusokat igényel.

Legal hold esetén garantálni kell, hogy a releváns adatok nem kerülnek törlésre, még akkor sem, ha azok deduplikált formában vannak tárolva.

Audit nyomvonalak

Deduplikált környezetben a hagyományos audit nyomvonalak nem mindig alkalmazhatók. Speciális logging mechanizmusokra van szükség a deduplikációs műveletek nyomon követéséhez.

Immutable audit logs biztosítják, hogy a nyomvonalak ne legyenek módosíthatók. Ez kritikus fontosságú a megfelelőségi követelmények teljesítéséhez.

A deduplikációs metaadatok változásainak naplózása segít megérteni, hogy mikor és miért történtek módosítások a rendszerben.

Milyen típusú adatok deduplikálhatók a leghatékonyabban?

A biztonsági mentések, virtuális gép lemezképek és irodai dokumentumok általában 70-90% deduplikációs arányt érnek el. Az adatbázis fájlok és tömörített tartalmak kevésbé deduplikálhatók.

Mennyi időbe telik egy deduplikációs rendszer implementálása?

Egy átlagos vállalati környezetben 2-6 hónap közötti időtartamra számíthatunk, a komplexitástól és a meglévő infrastruktúra integrációjának mértékétől függően.

Milyen biztonsági kockázatokkal jár a deduplikáció?

A fő kockázatok a hash ütközések, metaadat korrupció és az egyetlen pont hibalehetőség. Megfelelő redundancia és ellenőrzési mechanizmusokkal ezek minimalizálhatók.

Hogyan befolyásolja a deduplikáció a helyreállítási időket?

A deduplikáció általában csökkenti a helyreállítási időket a kisebb adatmennyiség miatt, azonban a metaadat rekonstrukció időigényes lehet nagy adatbázisok esetén.

Lehet-e deduplikációt alkalmazni titkosított adatokon?

A titkosított adatok deduplikálása rendkívül nehéz, mivel a titkosítás miatt az azonos tartalmú fájlok is különbözőnek tűnnek. Speciális megoldások léteznek erre a problémára.

Milyen hálózati sávszélesség szükséges a deduplikációs rendszerekhez?

A szükséges sávszélesség függ a deduplikációs aránytól és az adatmennyiségtől. Forrás-oldali deduplikáció esetén 80-90%-kal csökkenhet a hálózati forgalom.