A modern digitális világ szívében, ahol minden egyes kattintás, minden egyes keresés és minden egyes online interakció számít, a szerverek csendes hősökként dolgoznak a háttérben. Ezek a technológiai marvák nap mint nap szembenéznek a folyamatosan növekvő adatforgalommal, a hirtelen megnövekedő felhasználói igényekkel és a soha nem látott sebességű információáramlással. De vajon hogyan képesek ezek a gépek elviselni azt a hatalmas terhelést, amely napról napra egyre intenzívebb lesz?

A válasz összetettebb, mint azt elsőre gondolnánk. A szerverek világában minden egyes komponens, minden egyes algoritmus és minden egyes optimalizálási technika szerepet játszik abban, hogy a digitális infrastruktúra stabil maradjon még a legnagyobb forgalmi csúcsok idején is. Ez a komplex rendszer mögött rejlő tudomány és művészet egyszerre, amely évtizedek kutatásának és fejlesztésének eredménye.

Miért nő folyamatosan a szerverek terhelése?

A digitális átalakulás korában élünk, ahol a technológia minden területen jelen van. A globális internetforgalom exponenciálisan növekszik, és ez a trend nem mutat lassulás jeleit. A streaming szolgáltatások, a közösségi média platformok, az online játékok és a távmunka elterjedése mind hozzájárul ehhez a folyamatosan növekvő igényhez.

A helyzetet tovább bonyolítja, hogy az emberek elvárásai is változtak. Ma már természetesnek vesszük, hogy egy weboldal milliszekundumok alatt betöltődjön, hogy a videók akadásmentesen játszódjanak le, és hogy az alkalmazások azonnal reagáljanak a parancsainkra. Ez a „zéró türelem” kultúra óriási nyomást helyez a szerverekre és az őket üzemeltető infrastruktúrára.

A terhelés fő forrásai

A szerverek terhelését számos tényező befolyásolja, amelyek megértése kulcsfontosságú a hatékony kapacitástervezéshez:

🔥 Felhasználói forgalom ingadozása: A napi, heti és szezonális minták alapján a terhelés jelentősen változhat. Egy e-kereskedelmi oldal például Black Friday idején a szokásos forgalom többszörösét is tapasztalhatja.

💻 Alkalmazások komplexitása: A modern webalkalmazások egyre összetettebb funkcionalitást kínálnak, ami több szerver-oldali feldolgozást igényel. A mesterséges intelligencia integrálása, a valós idejű adatfeldolgozás és a személyre szabott tartalom szolgáltatása mind növeli a számítási igényeket.

📱 Mobil eszközök elterjedése: A mobilhasználat robbanásszerű növekedése új kihívásokat teremt, mivel a mobil alkalmazások gyakran más típusú szerverkapacitást igényelnek, mint a hagyományos webes alkalmazások.

🌐 IoT eszközök proliferációja: Az Internet of Things eszközök milliói kapcsolódnak a hálózathoz, folyamatos adatáramot generálva, amely mind a szerverek felé irányul.

🎯 Adatanalitika és gépi tanulás: A big data elemzések és a gépi tanulási algoritmusok futtatása hatalmas számítási kapacitást igényel, különösen a valós idejű döntéshozatal során.

Hogyan kezelik a szerverek a megnövekedett terhelést?

A modern szerverarchitektúra számos kifinomult technikát alkalmaz a növekvő terhelés kezelésére. Ezek a megoldások nem egyszerűen a hardver teljesítményének növelésére támaszkodnak, hanem intelligens szoftver- és infrastruktúra-optimalizálásra is.

Horizontális skálázás és terheléselosztás

A horizontális skálázás az egyik leghatékonyabb módszer a terhelés kezelésére. Ez a megközelítés azt jelenti, hogy több szerver dolgozik együtt egy feladat elvégzésén, ahelyett, hogy egyetlen nagy teljesítményű gépre támaszkodnánk.

A terheléselosztók kulcsszerepet játszanak ebben a folyamatban. Ezek az intelligens eszközök figyelik a bejövő kéréseket és automatikusan elosztják azokat a rendelkezésre álló szerverek között. A modern terheléselosztók nem csak egyszerűen körkörösen osztják el a kéréseket, hanem figyelembe veszik az egyes szerverek aktuális terhelését, válaszidejét és egészségi állapotát is.

| Terheléselosztási módszer | Előnyök | Hátrányok |

|---|---|---|

| Round Robin | Egyszerű implementáció, egyenletes elosztás | Nem veszi figyelembe a szerver teljesítményét |

| Weighted Round Robin | Figyelembe veszi a szerver kapacitását | Statikus súlyozás, nem adaptív |

| Least Connections | Dinamikusan a legkevésbé terhelt szerverre irányít | Nem veszi figyelembe a kapcsolatok komplexitását |

| IP Hash | Konzisztens routing ugyanazon felhasználó számára | Egyenlőtlen terheléselosztás lehetősége |

Gyorsítótárazási stratégiák

A gyorsítótárazás (caching) talán az egyik leghatékonyabb módszer a szerver terhelés csökkentésére. Ez a technika a gyakran használt adatok ideiglenes tárolását jelenti gyorsabb hozzáférési helyeken, így csökkentve a szerver és az adatbázis terhelését.

Többszintű gyorsítótárazási rendszerek alkalmazása különösen hatékony:

- CDN (Content Delivery Network): A statikus tartalmakat földrajzilag elosztott szervereken tárolja, így a felhasználók a hozzájuk legközelebb eső szerverről kapják meg az adatokat.

- Alkalmazásszintű cache: A szerver memóriájában tárolja a gyakran használt adatokat és számítási eredményeket.

- Adatbázis cache: Az adatbázis lekérdezések eredményeit tárolja, így ugyanazon lekérdezések esetén nem kell újra végrehajtani a költséges adatbázis műveleteket.

Mikroszolgáltatások architektúra

A mikroszolgáltatások megközelítése lehetővé teszi, hogy a nagy alkalmazásokat kisebb, független szolgáltatásokra bontsuk. Ez több szempontból is előnyös a terhelés kezelése szempontjából:

Először is, minden mikroszolgáltatás külön skálázható, így csak azokat a részeket kell erősíteni, amelyek valóban nagyobb terhelést kapnak. Másodszor, a hibák izolálhatók, így egy szolgáltatás meghibásodása nem befolyásolja a teljes rendszer működését.

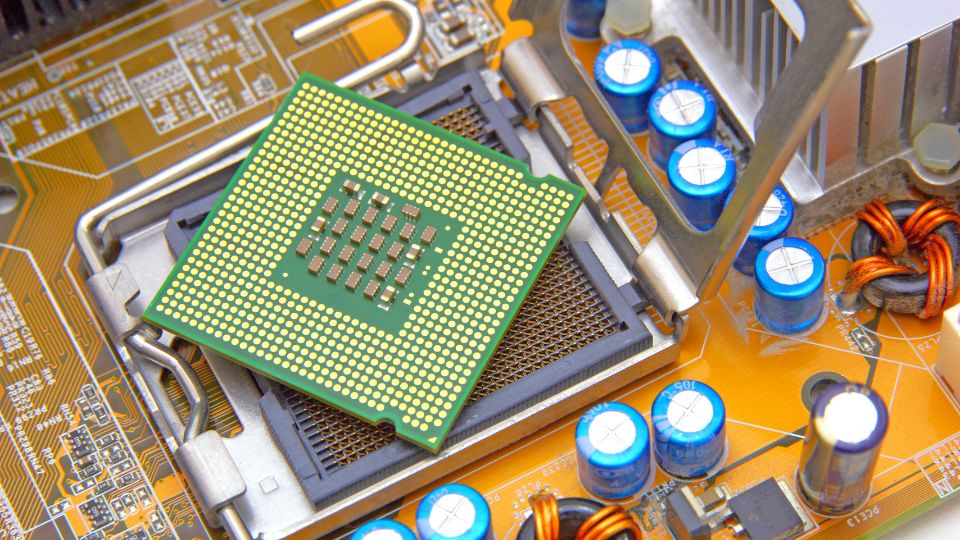

Milyen technológiák segítik a szerverek túlélését?

A modern szervertechnológiák palettája rendkívül széles és folyamatosan fejlődik. Ezek a technológiák együttesen biztosítják, hogy a szerverek képesek legyenek kezelni a növekvő igényeket.

Virtualizáció és konténerizáció

A virtualizáció forradalmasította a szerver-infrastruktúra kezelését. Egy fizikai szerveren több virtuális gép futhat, amelyek mindegyike saját operációs rendszerrel és alkalmazásokkal rendelkezik. Ez lehetővé teszi a hardver erőforrások hatékonyabb kihasználását és a gyorsabb skálázást.

A konténerizáció még egy lépéssel tovább megy. A konténerek könnyebbek a virtuális gépeknél, mivel megosztják a gazda operációs rendszer kernelét. Ez gyorsabb indítási időt és kisebb erőforrás-igényt eredményez.

Felhő-alapú megoldások

A felhő-számítástechnika teljesen megváltoztatta a szerver kapacitás kezelését. A felhő szolgáltatók, mint az Amazon Web Services, Microsoft Azure vagy Google Cloud Platform, gyakorlatilag végtelen skálázhatóságot kínálnak.

Az auto-scaling funkciók automatikusan növelik vagy csökkentik a szerver kapacitást a tényleges terhelés alapján. Ez azt jelenti, hogy a rendszer automatikusan reagál a forgalmi csúcsokra anélkül, hogy emberi beavatkozásra lenne szükség.

Adatbázis optimalizálás

Az adatbázisok gyakran a szűk keresztmetszetét jelentik a rendszer teljesítményének. Számos technika létezik az adatbázis terhelés csökkentésére:

- Indexelés: A megfelelő indexek jelentősen felgyorsítják a lekérdezéseket

- Particionálás: Nagy táblák kisebb részekre osztása

- Replikáció: Az adatok több szerveren történő tárolása

- Sharding: Az adatok horizontális elosztása több adatbázis között

Hogyan működik a valós idejű terhelésfigyelés?

A modern szerverek nem vakon dolgoznak – folyamatos monitorozás alatt állnak. A valós idejű terhelésfigyelés kritikus fontosságú a stabil működés biztosításához.

Monitorozási metrikák

A szerverek teljesítményét számos metrika alapján lehet értékelni:

| Metrika | Leírás | Kritikus érték |

|---|---|---|

| CPU használat | Processzor kihasználtság százalékban | >80% hosszabb ideig |

| Memória használat | RAM kihasználtság | >90% |

| Lemez I/O | Lemez írási/olvasási műveletek | Magas várakozási idő |

| Hálózati forgalom | Bejövő/kimenő adatforgalom | Sávszélesség-korlát közelében |

| Válaszidő | Kérések feldolgozási ideje | >2 másodperc |

Prediktív analitika

A gépi tanulás alkalmazása a szerver monitorozásban lehetővé teszi a problémák előrejelzését. Ezek a rendszerek a múltbeli adatok alapján képesek megjósolni, mikor várható nagyobb terhelés, és proaktívan készítik elő a szükséges erőforrásokat.

Mik a leggyakoribb szűk keresztmetszetek?

Minden rendszernek vannak gyenge pontjai, amelyek korlátozhatják a teljes teljesítményt. A szűk keresztmetszetek azonosítása és kezelése kulcsfontosságú a hatékony működéshez.

Hálózati korlátok

A hálózati sávszélesség gyakran válik szűk keresztmetszetté, különösen nagy mennyiségű adat átvitele esetén. A tartalomkézbesítő hálózatok (CDN) használata jelentősen csökkentheti ezt a problémát.

Adatbázis teljesítmény

Az adatbázis gyakran a leggyengébb láncszem. A lassú lekérdezések nemcsak az adott tranzakciót lassítják, hanem az egész rendszer teljesítményét is befolyásolhatják.

Alkalmazás szintű problémák

A rosszul optimalizált kód, a memóriaszivárgás vagy a nem hatékony algoritmusok mind hozzájárulhatnak a teljesítményproblémákhoz.

Hogyan készülnek fel a szerverek a jövő kihívásaira?

A technológia fejlődésével új kihívások is megjelennek. A 5G hálózatok elterjedése, az edge computing növekvő jelentősége és a kvantum-számítástechnika ígérete mind új lehetőségeket és kihívásokat teremt.

Edge computing

Az edge computing a számítási kapacitást közelebb viszi a végfelhasználókhoz. Ez csökkenti a központi szerverek terhelését és javítja a válaszidőt.

Mesterséges intelligencia integráció

Az AI-alapú optimalizálás lehetővé teszi a szerverek számára, hogy automatikusan alkalmazkodjanak a változó terheléshez és optimalizálják saját teljesítményüket.

Gyakori kérdések (GYIK)

Hogyan tudhatom meg, hogy a szervereink túlterheltek?

A szerver túlterhelés jelei könnyen felismerhetők, ha tudod, mire kell figyelned. A leggyakoribb tünetek közé tartozik a lassú válaszidő, a gyakori időtúllépések, a magas CPU és memória használat, valamint a növekvő hibaarányok.

A professzionális monitorozó eszközök, mint a Nagios, Zabbix vagy a New Relic, valós idejű riasztásokat küldenek, amikor a kritikus metrikák túllépik a beállított küszöbértékeket. Érdemes figyelni a következő jelzőszámokra: ha a CPU használat 80% felett van hosszabb ideig, a memória kihasználtság meghaladja a 90%-ot, vagy a lemez I/O várakozási ideje jelentősen megnő.

Melyik skálázási módszer a leghatékonyabb nagy forgalom esetén?

A horizontális skálázás általában hatékonyabb megoldás nagy forgalom kezelésére, mint a vertikális skálázás. Ez azért van, mert könnyebb és költséghatékonyabb több kisebb szervert hozzáadni a rendszerhez, mint egyetlen nagy teljesítményű gépet folyamatosan fejleszteni.

A horizontális skálázás további előnyei közé tartozik a jobb hibatűrés – ha egy szerver meghibásodik, a többi folytathatja a munkát. A mikroszolgáltatások architektúra különösen jól működik ebben a környezetben, mivel lehetővé teszi az egyes komponensek független skálázását.

Milyen költségekkel kell számolni a szerver kapacitás növelésénél?

A szerver kapacitás növelésének költségei több tényezőtől függnek. A felhő-alapú megoldások esetében általában pay-as-you-use modell szerint fizetsz, ami azt jelenti, hogy csak a ténylegesen használt erőforrásokért kell fizetned.

A saját szerverek esetében figyelembe kell venni a hardver beszerzési költségeket, az üzemeltetési kiadásokat (áram, hűtés, karbantartás), valamint a szakértői munkaerő költségeit. Hosszú távon gyakran a felhő-alapú megoldások bizonyulnak költséghatékonyabbnak, különösen a változó terhelésű alkalmazások esetében.

Hogyan lehet megelőzni a szerver összeomlást forgalmi csúcsok idején?

A szerver összeomlás megelőzése többrétegű megközelítést igényel. Elsősorban fontos a megfelelő kapacitástervezés – ez azt jelenti, hogy előre fel kell mérni a várható terhelést és ennek megfelelően kell méretezni a rendszert.

A terheléselosztás kritikus fontosságú – soha ne támaszkodj egyetlen szerverre. Implementálj redundanciát minden szinten, használj CDN-t a statikus tartalmak kiszolgálásához, és alkalmazz intelligens gyorsítótárazási stratégiákat.

Rendszeresen tesztelj terhelés alatt – a load testing segít azonosítani a gyenge pontokat, mielőtt azok valós problémát okoznának. Az auto-scaling funkciók automatikusan növelik a kapacitást, amikor szükséges.

Milyen szerepet játszik a CDN a szerver terhelés csökkentésében?

A Content Delivery Network (CDN) alapvetően megváltoztatja a szerver terhelés dinamikáját. A CDN a statikus tartalmakat (képek, CSS fájlok, JavaScript, videók) földrajzilag elosztott szervereken tárolja, így a felhasználók a hozzájuk legközelebb eső szerverről kapják meg ezeket az adatokat.

Ez jelentősen csökkenti a központi szerver terhelését, mivel a forgalom nagy része nem éri el a fő szervereket. Egy tipikus weboldalon a statikus tartalmak alkotják a forgalom 70-80%-át, így a CDN használata drámaian csökkentheti a szerver terhelést.

További előnyök közé tartozik a gyorsabb betöltési idő és a jobb felhasználói élmény, különösen a távoli felhasználók számára.

Hogyan optimalizálhatom az adatbázis teljesítményét nagy terhelés alatt?

Az adatbázis optimalizálás kulcsfontosságú a jó teljesítmény eléréséhez. Kezdd a lekérdezések optimalizálásával – győződj meg róla, hogy minden gyakran használt lekérdezéshez megfelelő indexek vannak létrehozva.

A connection pooling használata csökkenti az adatbázis kapcsolatok létrehozásának és bezárásának költségeit. Fontold meg a read replica-k használatát – ezek lehetővé teszik az olvasási műveletek elosztását több adatbázis szerver között.

Nagy adatmennyiség esetén a particionálás vagy sharding technikák alkalmazása jelentősen javíthatja a teljesítményt. A query cache használata szintén hatékony módszer a gyakran ismétlődő lekérdezések gyorsítására.

Mikor érdemes felhő-alapú megoldásra váltani?

A felhő-alapú megoldásra való váltás számos előnnyel jár, de nem minden esetben a legjobb választás. Érdemes megfontolni a felhőt, ha változó terhelésű alkalmazásod van, gyors skálázhatóságra van szükséged, vagy csökkenteni szeretnéd az IT infrastruktúra üzemeltetésének komplexitását.

A felhő különösen előnyös startup-ok és növekvő vállalkozások számára, mivel lehetővé teszi a kis kezdéssel való indulást és a fokozatos növekedést. A disaster recovery és backup megoldások is egyszerűbbek a felhőben.

Ugyanakkor, ha szigorú adatbiztonsági vagy compliance követelményeid vannak, vagy ha nagyon specifikus hardver igényeid vannak, a saját infrastruktúra lehet a jobb választás.

Hogyan mérjem a szerver teljesítmény javulását?

A szerver teljesítmény mérése objektív metrikákon alapul. A legfontosabb mutatók közé tartozik a válaszidő (response time), az áteresztőképesség (throughput), a hibaarány (error rate) és a rendelkezésre állás (uptime).

Használj baseline méréseket – mérj teljesítményt az optimalizálás előtt, hogy legyen összehasonlítási alapod. A folyamatos monitorozás elengedhetetlen – ne csak egyszeri mérésekre támaszkodj.

A felhasználói élmény metrikái ugyanilyen fontosak, mint a technikai mutatók. A Page Load Time, Time to First Byte (TTFB) és a Core Web Vitals mind jó indikátorai a valós teljesítménynek.

Terhelési tesztek segítenek megérteni, hogyan viselkedik a rendszer különböző terhelési szintek alatt. Ezeket rendszeresen el kell végezni, különösen jelentős változtatások után.

A teljesítmény javulásának dokumentálása és a stakeholderek számára való kommunikálása segít igazolni az optimalizálási befektetések értékét.